Материалы по тегу: microsoft azure

|

30.09.2025 [23:25], Владимир Мироненко

С 1 ноября клиентов гиперскейлеров вынудят покупать лицензии на VMware напрямую у Broadcom

aws

broadcom

google cloud platform

microsoft azure

software

vmware

виртуализация

гиперскейлер

лицензия

облако

В связи с отменой Broadcom бессрочных лицензий VMware и переходом на модель подписки BYOS (Bring Your Own Subscription, «принеси свою собственную подписку»), обеспечивающую переносимость лицензии на проверенные VMware решения на базе VMware Cloud Foundation (VCF), клиенты крупнейших облачных провайдеров должны с 1 ноября покупать подписки на VCF напрямую у неё, без посредников. Об изменениях отношений с гиперскейлерами Broadcom объявила в самом конце августа. Google Cloud Platform анонсировала изменения в работе сервиса Google Cloud VMware Engine (GCVE) от Google Cloud Platform (GCP), который позволяет запускать рабочие нагрузки на основе VMware в инфраструктуре Google Cloud, однако через несколько часов удалила запись. Тем не менее, копия сообщения прямо говорит, что теперь клиентам придётся обращаться за лицензиями и разрешением на их использование в GCP к Broadcom. Google первой среди гиперскейлеров предложила клиентам опцию Bring Your Own License (BYOL) для сред VMware в начале 2024 года. Согласно договорённости Google и Broadcom, пользователи GCP получат следующие возможности:

Для всех остальных заказчиков с 1 ноября 2025 года для развёртывания GCVE потребуется лицензия, купленная у Broadcom. Основные возможности VMware Engine для клиентов GCP останутся прежними. GCVE останется управляемой службой Google, которая предоставляет выделенную среду VMware Cloud Foundation, работающую непосредственно на инфраструктуре Google Cloud. Microsoft сообщила, что решение Azure VMware Solution (AVS) готово к изменениям в политике Broadcom. Вариант Azure VMware Solution VCF BYOL доступен во всех 35 регионах по всему миру. Цена варианта BYOL будет меньше, чем AVS с пакетной подпиской VCF. Microsoft прекратит продажу Azure VMware Solution с комплектной подпиской на VCF после 15 октября 2025 года. После этой даты для покупки новых узлов Azure VMware Solution потребуется подписка на VCF, приобретенная непосредственно у Broadcom. Узлы Azure VMware Solution с опцией PayGo смогут работать без дополнительных лицензий и изменений в продукте до 31 октября 2026 года. Клиенты могут перейти с AVS PayGo, приобретя до 15 октября 2025 года зарезервированные инстансы Azure VMware Solution с уже включённой подпиской VCF. AWS же в начала августа 2025 года, т.е. до публичного объявления Broadcom о смене политики лицензирования для клиентов гиперскейлеров, сообщила об общедоступности сервиса Amazon Elastic VMware Service (Amazon EVS), который позволяет запускать среды VCF в виртуальном частном облаке Amazon VPC и интегрировать их с другими сервисами AWS. При этом лицензии так же придётся покупать у Broadcom, причём минимум на 256 ядер. Нюанс в том, что EVS пока поддерживает только VCF версии 5.2.1 и только на узлах i4i.metal на базе Intel Xeon Ice Lake-SP.

25.09.2025 [13:31], Руслан Авдеев

Суверенный ChatGPT для Германии: SAP, OpenAI и Microsoft анонсировали проект OpenAI for Germany

microsoft

microsoft azure

openai

sap

software

германия

информационная безопасность

конфиденциальность

облако

сделка

Немецкая SAP SE и OpenAI сообщили о запуске проекта OpenAI for Germany. Партнёры намерены внедрить в государственный сектор Германии технологии SAP для корпоративных приложений и передовые решения OpenAI в сфере искусственного интеллекта, сообщает пресс-служба OpenAI. Для выполнения требований к суверенитету данных проект OpenAI for Germany будет реализован на платформе дочерней структуры SAP — SAP Delos Cloud, работающей на платформе Microsoft Azure. Это позволит миллионам госслужащих безопасно использовать ИИ, соблюдая строгие стандарты для обеспечения суверенитета, безопасности и законности использования информации. В SAP заявляют, что с её опытом внедрения ИИ-функций для бизнеса и десятками лет взаимодействия с государственными организациями, компания рассматривает OpenAI for Germany как огромный шаг вперёд. Экспертиза SAP Sovereign Cloud объединится с передовыми ИИ-технологиями OpenAI для эффективного использования ИИ-решений, разработанных «в Германии и для Германии». По словам главы OpenAI Сэма Альтмана (Sam Altman), Германия давно является пионером в области инженерных решений и технологий, поэтому неудивительно, что миллионы немцев пользуются ChatGPT, чтобы упростить себе жизнь, вывести на новый уровень научные достижения и организовать новые бизнесы. С помощью нового проекта OpenAI рассчитывает работать с местными партнёрами, чтобы распространить потенциал ИИ-технологий на госсектор, способствуя улучшению сервисов и обеспечивая распространение ИИ по всей стране в соответствии с немецкими ценностями, касающимися доверия и безопасности.

Источник изображения: Adeolu Eletu/unspalsh.com Наконец, глава Microsoft Сатья Наделла (Satya Nadella) заявил, что новое партнёрство позволит его компании предоставить государственному сектору Германии больше возможностей в сфере ИИ. Основой этого станет облако Azure (как платформа для Delos Cloud), что поможет обеспечить внедрение ИИ с соблюдением высочайших стандартов, касающихся суверенитета и конфиденциальности данных, с соответствием работы местным нормативным требованиям и другим параметрам. Это позволит госучреждениям уверенно и ответственно внедрять ИИ. В рамках нового партнёрства, старт которого запланирован на 2026 год, OpenAI, SAP и Microsoft намерены упростить повседневную работу местным чиновникам, сотрудникам научно-исследовательских структур и др. — для того, чтобы появилась возможность уделять больше времени людям, а не бумажной работе, заявляют компании. Кроме того, OpenAI for Germany послужит основой для разработки специализированных приложений для госструктур и интеграции ИИ-агентов в действующие рабочие процессы вроде управления документооборотом или анализа административных данных. Для этого SAP намерена расширить имеющуюся инфраструктуру Delos Cloud в Германии до 4 тыс. ИИ-ускорителей. В зависимости от спроса в будущем, SAP, возможно, продолжит инвестировать в развитие прикладной ИИ-функциональности в Германии, масштабируя проекты как за счёт имеющейся инфраструктуры SAP, так и за счёт сотрудничества с партнёрами. Не исключается расширение предложения суверенных решений на другие отрасли и рынки по всей Европе. OpenAI for Germany поддерживает местные амбиции, касающиеся внедрения ИИ. Местная повестка, касающаяся высоких технологий, направлена на «создание дополнительной стоимости» с помощью ИИ на уровне до 10 % ВВП к 2030 году. Более того, в рамках инициативы Made for Germany, поддерживаемой 61 крупной компанией, планируется привлечь €631 млрд на ускорение роста и IT-модернизацию страны. Сама SAP недавно заявляла о намерении инвестировать более €20 млрд в укрепление цифрового суверенитета Германии, в том числе в облако Delos.

08.09.2025 [17:48], Владимир Мироненко

Microsoft предоставила скидки госагентствам США на более чем $6 млрд

microsoft

microsoft 365

microsoft azure

microsoft copilot

software

госзакупки

ии

облако

сделка

сша

финансы

Управление общих служб США (GSA) объявило о заключении соглашения с Microsoft в рамках новой политики закупок OneGov, введённой администрацией Дональда Трампа (Donald Trump) и призванной консолидировать ИТ-расходы через единый канал. Вместо того чтобы каждое ведомство заключало собственные контракты, OneGov предписывает им осуществлять закупки через GSA. Новое соглашение предусматривает значительные скидки на пакет облачных сервисов, который Microsoft предоставит агентствам США, включая Microsoft 365, Copilot, Azure, Dynamics 365, а также инструменты кибербезопасности и мониторинга, и даже семинары по внедрению, адаптации и оптимизации, что позволит сэкономить им $3,1 млрд в первый год. В частности, Microsoft 365 Copilot будет предоставляться бесплатно клиентам Microsoft G5 в течение до 12 месяцев с дополнительными скидками в последующие годы, что свидетельствует о намерении Microsoft сделать своего ИИ-помощника стандартным элементом правительственных рабочих процессов. Microsoft 365 G3 и G5 — планы лицензирования для государственных учреждений с различными уровнями безопасности и функциональности. G5 специально разработан для сред, требующих повышенной безопасности, и включает в себя дополнительные функции, такие как аналитика в режиме реального времени, защита от угроз, Power BI Pro и расширенные возможности корпоративной телефонии. Федеральные агентства могут воспользоваться всеми этими предложениями или любыми из них до сентября 2026 года, при этом скидки на некоторые продукты будут действовать до 36 месяцев. Чтобы получить право на льготы, агентства должны пройти процедуру GSA в рамках OneGov. Не все агентства имеют право на более низкие ставки. За полный трёхлетний период общая экономия правительственных агентств может превысить $6 млрд, что делает предоставляемые Microsoft скидки одними из самых крупных среди предоставленных компаниями правительству, отметил ресурс Windows Central. Генеральный директор Microsoft Сатья Наделла (Satya Nadella) лично участвовал в подписании соглашения, пообщавшись напрямую с Джошем Грюнбаумом (Josh Gruenbaum), главой Федеральной службы закупок (Federal Acquisition Service), что демонстрирует, насколько важна эта сделка для компании. Сделки с GSA в рамках OneGov заключил целый ряд компаний. Adobe предложила скидку 70 % на своё решение для безбумажного правительства, доступное до ноября 2025 года. Соглашение с Amazon предполагает предоставление всем агентствам облачных кредитов на сумму до $1 млрд на модернизацию их инфраструктуры, а также большую экономию в рамках прямых контрактов. В свою очередь, Google представила скидку 71 % на Google Workspace. В сфере ИИ скидки ещё более внушительные. Claude for Enterprise от Anthropic доступен для всех трёх ветвей власти всего за $1 на агентство, OpenAI предлагает ChatGPT Enterprise по такой же цене. Однако соглашение действует только один год. GSA контролирует около $110 млрд расходов на общие товары и услуги, предоставляемые многими агентствами, включая около $80 млрд расходов, связанных с ИТ. Годовой доход Microsoft от правительственных контрактов, вероятно, составляет несколько миллиардов долларов, сказал Грюнбаум, о чём сообщает CNBC. Вместе с тем некоторые эксперты считают продукты Microsoft угрозой национальной безопасности из-за многочисленных уязвимостей. Кроме того, компанию подозревали в антиконкурентном поведении ради сохранения правительственных контрактов.

30.08.2025 [14:19], Руслан Авдеев

Пентагон отказался от китайских сотрудников техподдержки Microsoft, но расследование продолжается

microsoft

microsoft azure

software

аутсорсинг

госзакупки

информационная безопасность

китай

облако

пентагон

поддержка

сша

В Пентагоне осудили использование Microsoft сотрудников китайского подразделения компании для поддержки облачных сервисов Azure, развёрнутых государственными ведомствами США. Военные требуют от Microsoft провести собственное расследование и определить, были ли факты компрометации конфиденциальных данных, сообщает The Register. В июле 2025 года появилась информация, что Министерство обороны США (DoD) невольно почти 10 лет допускало Пекин к своим важнейшим системам. Часть важных задач была передана Microsoft на аутсорс китайским коллегам. При этом власти неоднократно жаловались, что Китай использует уязвимости в IT-системах для разведки и подрыва национальной безопасности США. Делегировать китайским сотрудникам работу с данными Пентагона — весьма странный шаг со стороны Microsoft. Пока ни один из конкурентов компании не признавался в аналогичной «оптимизации» рабочих процессов. По словам министра обороны США Пита Хегсета (Pete Hegseth), несмотря на то что компания специально оптимизировала свою политику работы с китайскими коллегами, чтобы та соответствовала правилам американских государственных контрактов, риск всё равно неприемлем: «Меня поражает, что я вообще говорю такое <…> и что мы вообще позволили этому случиться». Хотя в Microsoft утверждают, что за этими сотрудниками наблюдали сотрудники Пентагона с допуском к государственной тайне, Хегсет объявил о расследование вскрывшихся фактов.

Источник изображения: Jefferson Santos/unsplash.com Разработчики из Китая более не поддерживают информационные системы Министерства обороны США, но расследования Пентагона и самой Microsoft продолжаются. Военные направили Microsoft официальное письмо с «выражением обеспокоенности» и требуют независимого аудита той информации, которая была предоставлена гражданам Китая. Также само Министерство обороны намерено расследовать инцидент в поисках возможного «негативного влияния» на облачные системы Пентагона извне. Кроме того, выявить и прекратить участие китайских специалистов в обеспечении работы облачных сервисов требуют и от других поставщиков ПО военному ведомству. Однажды Microsoft уже уличили в небрежном обращении с государственными данными. В 2023 году Китай, предположительно, взломал Exchange Online Министерства торговли США и Госдепартамента, а в июле злоумышленники использовали уязвимость в Sharepoint для атаки «крупного западного правительства». По словам бывших сотрудников Белого дома, некоторые считают Microsoft угрозой национальной безопасности — удивительно, почему компания до сих пор получает средства, в том числе на обслуживание Пентагона, несмотря на регулярные провалы. Некоторые эксперты утверждают, что китайцы хорошо ориентируются в продуктах Microsoft, поэтому в случае крупного конфликта обязательно нанесут удар по критически важной инфраструктуре посредством сервисов и продуктов компании. При этом отмечается, что недавнее объявление о прекращении поддержки сервисов Microsoft специалистами из Китая касается только военного ведомства и связанных с ним сервисов, но о прекращении поддержки других госучреждений ничего не говорится. Компания лишь сообщила журналистам, что стремится предоставлять правительству «максимально безопасные услуги», включая привлечение партнёров для оценки и корректировки протоколов безопасности по мере необходимости. Предыдущие просчёты не особенно сказались на бизнесе Microsoft, при этом в результате некоторых инцидентов произошла кража конфиденциальных данных. Эксперты надеются, что Трамп разберётся с Microsoft из-за её халатного отношения к безопасности.

14.08.2025 [13:57], Руслан Авдеев

Windows 365 Reserve предложит на время облачный ПК на случай проблем с физическимПользователи Windows 11 смогут пользоваться виртуальными копиями своих компьютеров в облаке в случае поломки ПК. Компаниям предлагается доступ к виртуальным машинам в облаке Azure, если откажет железо или программное обеспечение, сообщает The Register. По словам Microsoft, в условиях постоянного подключения к Сети сбой даже одного устройства может негативно сказаться на работе всей организации, что снизит производительность, создаст дополнительную нагрузку на IT-отделы и др. Как заявляют в компании, если возможные сбои умножить на тысячи сотрудников, последствия станут «колоссальными». Для тех, кто хочет сохранить работоспособность IT-инфраструктуры в любых условиях, предлагается сервис Windows 365 Reserve. Он позиционируется как современное, безопасное и масштабируемое решение, помогающее сотрудникам сохранять продуктивность и быть на связи даже в непредвиденных обстоятельствах. Сервис предназначен для бизнес-пользователей, при этом подписка Reserve не связана с основным продуктом Windows 365.

Источник изображения: Jonathan Borba/unspalsh.com Клиенты могут получить доступ к «временному, безопасному и выделенному облачному ПК», пользоваться которым можно будет до 10 дней, если основная машина выйдет из строя. Виртуальные машины размещаются на облачной платформе Microsoft и управляются через Microsoft Intune, так что их можно предварительно настроить для быстрого развёртывания. Проблема в том, что для использования такого облачного ПК всё равно потребуется ещё одно устройство, имеющее хотя бы рабочий веб-браузер — желательно… ещё один ПК. Ещё одно препятствие для пользователей Windows 365 Reserve — проблема «масштабирования» в случаях, когда неудачное обновление, атака вируса или другая масштабная проблема одновременно оставит без возможности использовать традиционные ПК сразу несколько пользователей. В Microsoft признают, что Windows 365 Reserve ограничен ёмкостью облака Azure и, конечно, требует сетевого подключения для использования виртуального ПК. Пока желающие протестировать Windows 365 Reserve могут подать заявку для доступа к закрытой бета-версии. Участвовать могут только избранные: клиенты Microsoft, MVP-эксперты или партнёры компании, у которых есть лицензии Windows E3, Intune и Azure Active Directory P1 (AADP1). Участники бета-теста Windows 365 Reserve должны выполнить набор тестовых сценариев — как для администраторов, так и для конечных пользователей, предоставив обратную связь о своём опыте использования нового сервиса. Соискателям с одобренными заявками будет предоставлен бесплатный доступ к платформе на срок до 12 недель.

31.07.2025 [14:25], Владимир Мироненко

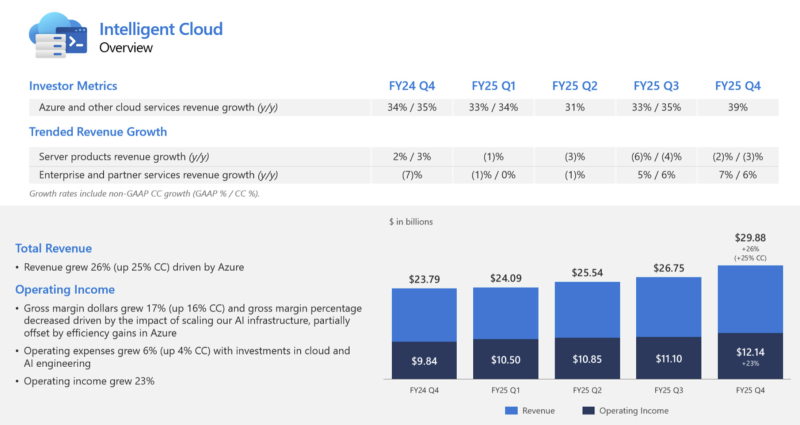

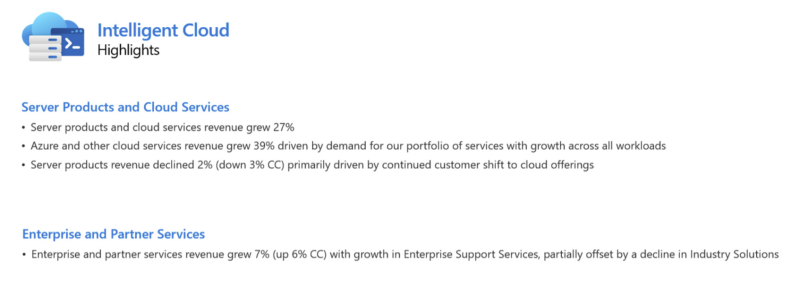

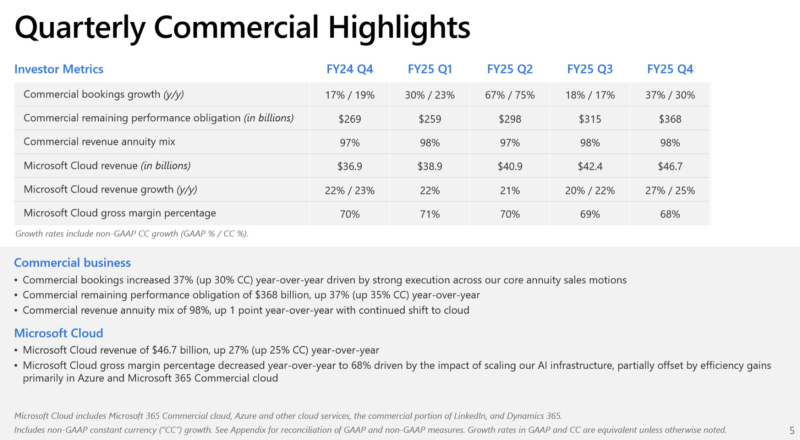

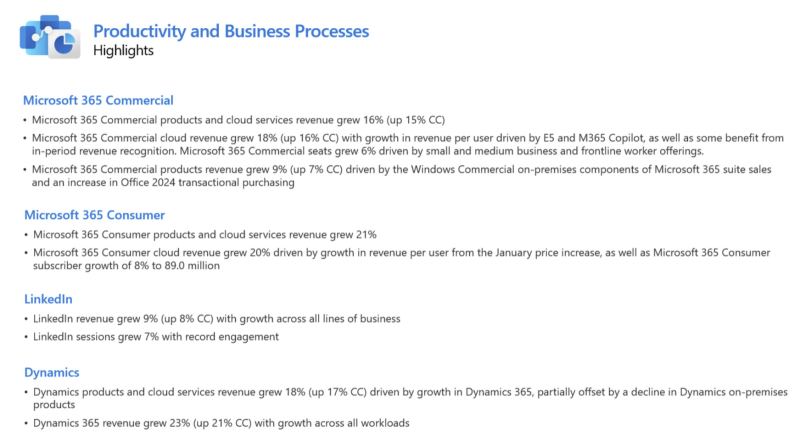

Microsoft увеличила выручку и впервые раскрыла цифры по AzureАкции Microsoft выросли на 9 % в ходе расширенных торгов после публикации компанией отчёта за IV квартал 2025 финансового года, согласно которому её прибыль и выручка превысили ожидания аналитиков. Благодаря росту акций рыночная капитализация Microsoft превысила отметку в $4 трлн, всё же уступая NVIDIA, которая преодолела данный рубеж ранее в этом месяце, отметил ресурс Siliconangle. Microsoft также впервые раскрыла годовой доход облачной платформы Azure, что позволило акционерам получить представление о её положении в облачном сегменте по сравнению с Amazon и Google. Выручка Microsoft за отчётный период выросла на 18 % до $76,44 млрд, превысив консенсус-прогноз аналитиков, опрошенных LSEG, в размере $73,81 млрд. Это самый быстрый рост показателя за более чем три года. Чистая прибыль увеличилась на 24 % до $27,23 млрд с $22,04 млрд годом ранее. Чистая прибыль на акцию составила $3,65 по сравнению с $3,37 согласно консенсус-прогнозу аналитиков, опрошенных LSEG. «Мы завершили финансовый год с сильным кварталом, о чем свидетельствует выручка от Microsoft Cloud, достигшая $46,7 млрд, что на 27 % больше по сравнению с аналогичным периодом прошлого года», — отметила Эми Худ (Amy Hood), исполнительный вице-президент и финансовый директор Microsoft. Выручка подразделения Microsoft Intelligent Cloud, в которое входят облачные сервисы Azure, а также Windows Server, SQL Server, GitHub, Nuance, Visual Studio и корпоративные сервисы, составила $29,88 млрд (рост год к году на 26 %), что превзошло консенсус-прогноз StreetAccount в $28,92 млрд. Компания сообщила, что выручка облачной платформы Microsoft Azure за 2025 финансовый год превысила $75 млрд, что на 34 % больше, чем годом ранее. Это обусловлено не только спросом на ИИ, но и «ростом во всех рабочих нагрузках», указал генеральный директор Microsoft Сатья Наделла (Satya Nadella) в отчёте. Для сравнения, согласно данным Alphabet, о чём сообщает The Wall Street Journal, годовая выручка Google Cloud превысила $50 млрд, а у AWS — более $111 млрд (с учётом итогов завершившегося в марте квартала). В IV финансовом квартале выручка Azure выросла на 39 %. Аналитики, опрошенные StreetAccount и CNBC, прогнозировали рост Azure на 34,4 % и 35,3 % соответственно. Компания заявила, что ожидает рост на 37 % в текущем квартале, что превзошло прогнозы аналитиков в 33,5 % (согласно данным Visible Alpha), о чём сообщает Reuters. Выручка подразделения Microsoft Productivity and Business Processes составила $33,11 млрд (рост год к году на 16 %), превысив консенсус-прогноз в $32,12 млрд аналитиков, опрошенных StreetAccount. Сатья Наделла рассказал о том, как ставка компании на ИИ, включая значительные инвестиции в OpenAI и многомиллиардные затраты на чипы NVIDIA, способствует росту продаж ПО в этом подразделении. Он отметил, что интеграция Microsoft 365 Copilot с инструментами повышения производительности привела к заметному росту дохода на одного пользователя таких продуктов, как Office. В настоящее время насчитывается более 100 млн активных пользователей инструментов Copilot в месяц, включая Microsoft 365 Copilot для коммерческих клиентов и помощника Copilot для потребителей в Windows. Ставка Microsoft на ИИ, включая инвестиции в OpenAI и миллиарды долларов, потраченные на чипы NVIDIA, способствует росту продаж бизнес-ПО, отметил Сатья Наделла. Он подчеркнул, что интеграция Microsoft 365 Copilot с инструментами повышения производительности привела к заметному росту дохода в расчёте на пользователя таких продуктов, как Office. Количество активных пользователей продуктов Copilot, включая Microsoft 365 Copilot для коммерческих клиентов и помощника Copilot для пользователей Windows, составляет 100 млн ежемесячно, сообщил Наделла. Аналитик Valoir Ребекка Веттеманн (Rebecca Wettemann) сообщила SiliconANGLE, что комментарии Наделлы обнадёживают, но отметила, что компания всё ещё испытывает трудности с ростом популярности ИИ по сравнению с некоторыми конкурентами. «Microsoft медленнее, чем некоторые конкуренты, добивается успеха в области ИИ», — сказала аналитик. «Поскольку конкуренты начинают хвастаться корпоративными референциями и говорить о цифрах внедрения, Microsoft необходимо последовать их примеру, чтобы опровергнуть мнение о том, что Copilot всё ещё слишком дорог для широкого внедрения среди клиентов», — предложила она. Подразделение More Personal Computing увеличило выручку на 9 % до $13,45 млрд, что выше консенсус-прогноза StreetAccount в размере $12,68 млрд. Капитальные затраты Microsoft выросли год к году на 27 % до $24,2 млрд, по сравнению с прогнозом аналитиков в $23,08 млрд (согласно Visible Alpha), поскольку компания продолжает активно развивать инфраструктуру ИИ ЦОД. Ещё $1,71 млрд списаны на другие расходы, включая убытки от инвестиций в долевое участие в компаниях, включая OpenAI. Эми Худ сообщила, что компания прогнозирует выручку за I финансовый квартал в пределах от $74,7 до $75,8 млрд со средним показателем в размере $75,25 млрд, превосходящем консенсус-прогноз LSEG в $74,09 млрд Прогноз по операционной рентабельности в размере 46,6 % превышает консенсус-прогноз аналитиков, опрошенных StreetAccount, в 45,7 %. Прогноз Microsoft включает более $30 млрд на капзатраты и активы, приобретённые по финансовой аренде, что в итоге обеспечит рост год к году более 50 %. Аналитики, опрошенные Visible Alpha, ожидают около $24,23 млрд. Microsoft заявила, что её капитальные расходы несколько сместились в сторону активов с длительным сроком службы, таких как ЦОД, хотя ранее компания сообщила инвесторам, что в 2026 финансовом году структура капитальных расходов сместится в сторону активов с малым сроком службы, таких как чипы.

27.07.2025 [23:55], Владимир Мироненко

Microsoft признала, что не может гарантировать суверенитет данных в Европе

aws

microsoft

microsoft azure

software

гиперскейлер

европа

евросоюз

закон

информационная безопасность

конфиденциальность

облако

сша

франция

Microsoft «не может гарантировать» суверенитет данных клиентам во Франции, и, как следствие, всему Европейскому союзу, если администрация Трампа потребует доступ к информации о клиентах, хранящейся на её серверах, пишет The Register. Об этом сообщил, выступая перед Сенатом Франции в рамках расследования государственных закупок и их роли в обеспечении цифрового суверенитета Европы, Антон Карньо (Anton Carniaux), директор по связям с общественностью и правовым вопросам французского отделения Microsoft. Согласно Акту о законном использовании данных за рубежом (The Cloud Act), правительство США наделено правом получать цифровые данные, хранящиеся у американских технологических корпораций, причём в независимости от того, хранятся ли эти данные на серверах внутри страны или за рубежом, и даже если эти данные принадлежат не гражданам США. Отвечая на вопрос о технических или юридических механизмах, которые могли бы помешать такому доступу в соответствии с The Cloud Act, Карньо заявил, что компания «имеет договорное обязательство перед своими клиентами, включая клиентов государственного сектора, отклонять эти запросы, если они необоснованны». Ранее Microsoft заверила, что работа облачных сервисов в ЕС будут контролироваться местным советом директоров и действовать в соответствии с местным законодательством. Карньо подчеркнул, что правительство не может делать запросы, которые не имеют чёткого определения — если такие запросы поступают, компания просит о возможности уведомить об этом соответствующего клиента. Карньо также спросили, может ли он, как представитель руководства Microsoft, в случае юридически обоснованного судебного запрета «гарантировать нашему комитету под присягой», что данные французских граждан не будут переданы американскому правительству без явного согласия французского правительства. «Нет, — сказал Карньо, — я не могу этого гарантировать, но, опять же, такого никогда раньше не случалось». Марк Буст (Mark Boost), генеральный директор облачного провайдера Civo, заявил: «Одна строка показаний только что подтвердила, что американские гиперскейлеры не могут гарантировать суверенитет данных в Европе». По его словам, Microsoft открыто признала то, что многим давно известно: согласно законам вроде The Cloud Act власти США могут принудительно запрашивать доступ к данным, хранящимся у американских провайдеров облачных услуг, независимо от того, где эти данные физически хранятся. «Это больше, чем просто формальность. Это реальная проблема, которая может повлиять на национальную безопасность, конфиденциальность персональных данных и конкурентоспособность бизнеса», — заявил Марк Буст. Параллельно на этой неделе AWS пояснила некоторые моменты реализации требований The Cloud Act в связи с ростом числа «запросов о том, как мы обрабатываем запросы государственных органов на предоставление данных». AWS утверждает, что закон не предоставляет правительству США «беспрепятственный или автоматический доступ к данным, хранящимся в облаке». The Cloud Act позволил США заключать взаимные исполнительные соглашения с доверенными иностранными партнёрами с целью получения доступа к электронным доказательствам для расследования тяжких преступлений, где бы эти доказательства ни находились, устранив препятствия, предусмотренные законодательством США. «Согласно законодательству США, провайдерам фактически запрещено раскрывать данные правительству США при отсутствии предусмотренного законом исключения», — сообщила AWS. — «Чтобы обязать провайдера раскрыть данные, правоохранительные органы должны убедить независимого федерального судью в наличии причины, связанной с конкретным преступлением, и в том, что доказательства преступления будут обнаружены там, где должен быть произведён обыск». AWS заявила, что до этого момента не раскрывала данные корпоративных или государственных клиентов в соответствии с законом The Cloud Act. По словам AWS, принципы закона «соответствуют международному праву и законам других стран»; и закон «не ограничивает технические меры и операционные средства контроля, которые AWS предлагает клиентам для предотвращения несанкционированного доступа к их данным». И последний аргумент AWS, который явно направлен против европейских конкурентов, пытающихся воспользоваться движением за суверенитет данных, заключается в том, что The Cloud Act распространяется не только на компании с головным офисом в США, но и на всех «поставщиков услуг электронной связи или удалённых вычислений», ведущих бизнес в США. То есть поставщики облачных услуг со штаб-квартирой в Европе, ведущие деятельность в США, также подпадают под его действие. Microsoft, AWS и Google пытаются заверить обеспокоенных клиентов в ЕС в том, что они смогут обеспечить суверенитет данных при не совсем дружелюбной позиции США по отношению к странам, некогда считавшимся близкими союзниками. Несмотря на это, в ЕС наблюдается тенденция на создание суверенной инфраструктуры, отметил The Register, хотя не все поддерживают эту идею. Более того, многие в Европе смирились с тем, что без американских облаков уже не обойтись. Согласно данным Synergy Research Group, доля локальных игроков на облачном рынке Европы замерла на уровне 15 %. При этом часть из них ещё и попала в зависимость от новой политики Broadcom в отношении VMware.

03.06.2025 [10:10], Владимир Мироненко

Благодаря ИИ Microsoft из отстающих вышли в лидеры по темпам роста своих акцийПосле нескольких месяцев затишья акции Microsoft возобновили рост, вплотную приблизившись к рекордному максимуму на фоне признаков возвращения к норме бизнеса Azure, пишет Bloomberg. Сейчас акции Microsoft торгуются всего на 2 % меньше рекордного уровня, достигнутого в июле прошлого года, после роста на 16 % в мае, что сделало его лучшим месяцем для компании за более чем три года. Рост акций был обусловлен более широким восстановлением позиций акций американских компаний, а также лучшими, чем ожидали на Уолл-стрит, результатами Azure. Как полагают инвесторы, эта тенденция сохранится, поскольку ИИ становится драйвером роста бизнеса. «ИИ становится всё более важной составляющей доходов», — отметила Нэнси Тенглер (Nancy Tengler), гендиректор инвестиционной компании Laffer Tengler Investments. Темпы роста акций Microsoft резко увеличились по сравнению с прошлым годом, когда из-за опасений инвесторов по поводу отставания компании в гонке ИИ и разочаровывающего роста Azure по сравнению с облачными платформами конкурентов акции софтверного гиганта выросли всего на 12 %. Это был худший показатель среди так называемой «великолепной семёрки», также включающей Apple, NVIDIA, Alphabet, Amazon, Meta✴ и Tesla. В этом году Microsoft с ростом акций на 9 % обошла всех участников семёрки, за исключением Meta✴, у которой рост акций составил 10 %. Помимо того, что Microsoft значительно улучшила финансовое положение, она, в отличие от многих конкурентов, выиграла от введения пошлин новой администрацией США, пишет Bloomberg. Аналитики TD Cowen опубликовали прогноз, согласно которому выручка Azure, связанная с ИИ, вырастет примерно до $24 млрд в 2026 финансовом году с около $4 млрд в 2024 финансовом году. Аналитики повысили целевую цену акций до $540 с $490, что подразумевает потенциальный прирост примерно на 18 % по сравнению с ценой на момент закрытия торгов в прошлую среду. Из 72 аналитиков, опрошенных Bloomberg, которые отслеживают деятельность Microsoft, никто не рекомендует продавать её акции. При прогнозируемом соотношении цены и прибыли на акцию в 30 на следующие 12 месяцев Microsoft оценивается с премией к среднему показателю Nasdaq 100 и собственному 10-летнему среднему показателю в размере около 26, пишет Bloomberg. По мнению Кевина Уолкуша (Kevin Walkush), управляющего портфелем в Jensen Investment Management, акции Microsoft продолжат расти, поскольку компания будет генерировать растущую долю дохода от ИИ-сервисов. «Microsoft, вероятно, является одной из лучших долгосрочных возможностей в ИИ», — заявил он.

30.05.2025 [09:34], Руслан Авдеев

Microsoft закрепляет лидерство в сфере ИИ, предлагая клиентам почти 2 тыс. моделей, в том числе от конкурентовКомпания Microsoft сделала серьёзную заявку на мировое лидерство в сфере искусственного интеллекта, в своё время инвестировав $13 млрд в стартап OpenAI. Позже компания использовала GPT-модели OpenAI в качестве основы для собственного бота Copilot AI, интегрировав его во многие свои продукты, а теперь вышла на новый уровень, сообщает Computer World. Компания запустила хостинг LLM и ИИ-сервисов крупнейших в мире ИИ-компаний и стартапов, включая собственных конкурентов — всего более 1900 моделей, от Llama AI (Meta✴) до разработок xAI и европейских стартапов Mistral и Black Forest Labs, а также китайского DeepSeek и др. Другими словами, даже если Copilot не оправдает ожиданий Microsoft в полной мере, она в какой-то степени разделит и успехи своих конкурентов и, вероятно, останется крупнейшей в мире ИИ-компанией. ЦОД Microsoft стали залогом её успеха на рынке искусственного интеллекта. Благодаря сделке с OpenAI сама Microsoft получает отчисления от каждого подписчика OpenAI. Для монетизации ИИ-решений в 2023 году Microsoft запустила сервис Azure OpenAI, позволяющий клиентам Azure создавать приложения с использованием моделей OpenAI. По некоторым данным, в сервисе зарегистрировано около 60 тыс. клиентов.

Источник изображения: Craig Sybert/unsplash.com Бизнес компании растёт и благодаря договорённостями с другими ИИ-разработчиками. В середине мая Microsoft объявила о размещении моделей Grok в сервисе Azure AI Foundry. Кроме того, в облаке Microsoft размещены и другие популярные модели. Таким образом, Microsoft получает больше денег даже в том случае, когда конкуренты добиваются новых успехов. Недавно компания подробно рассказала о видении того, каким образом компании смогут создавать ИИ-агентов для выполнения широкого спектра задач. В центре внимания — Azure AI Foundry, позволяющий клиентам создавать ИИ-агентов, использую любую из почти 2 тыс. моделей и объединяя их возможности, в том числе, например, для работы на GutHub. Другими словами, заказчикам не придётся подписываться на использование моделей у каждой из компаний по отдельности.

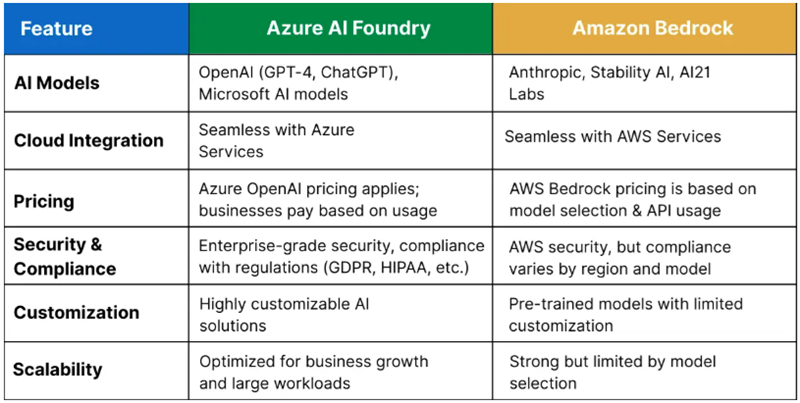

Источник изображения: Q Service Хотя крупнейшим облачным оператором в мире является Amazon (AWS), Microsoft постепенно сокращает разрыв, а подобные площадки для работы с разными ИИ-моделями обеспечивают ей большую фору. Amazon с аналогом Azure AI Foundry — Amazon Bedrock пыталась повторить нечто подобное, но ИИ-моделей у неё гораздо меньше. Высока вероятность, что в этой схватке первенство останется за Microsoft. По расчётам экспертов Q Services, предложение Bedrock лучше подходит разве что для стартапов и компаний, занимающихся разработкой, а Microsoft доминирует на более широком рынке, в том числе сотрудничая с крупными корпорациями. Большое преимущество компании — в использовании всех продуктов, от Microsoft 365 до Azure для продажи существующим клиентам сервисов Azure AI Foundry. У Amazon такая уникальная возможность отсутствует.

29.05.2025 [18:29], Руслан Авдеев

Microsoft запустила свой первый облачный регион в МалайзииКомпания Microsoft запустила свой первый облачный регион в Малайзии. Malaysia West, расположенный в Куала-Лумпуре, теперь доступен всем желающим, сообщает Datacenter Dynamics. По информации самой Microsoft, регион состоит из трёх зон доступности и классифицирован как «готовый к ИИ» (AI Ready). Малайзийские организации получат доступ к облачным сервисам Microsoft, данные будут размещаться внутри страны. Как заявляют в Министерстве цифровых технологий Малайзии, с новым облачным регионом страна сможет использовать новейшие цифровые и ИИ-технологии для повышения добавленной стоимости и освоения более сложных звеньев производственной цепочки. Утверждается, что правительство заложило основу для этого, разработав первоклассную и надёжную цифровую среду для процветания бизнеса — она соответствует принципам «доверенного облака» Microsoft. По словам представителя Microsoft, компания стремится стать партнёром Малайзии в её ИИ-трансформации, а облачный регион Malaysia West обеспечит для этого инфраструктуру ИИ ЦОД мирового класса и позволит местным организациям и компаниям более безопасно ускорить инновации.

Источник изображения: Hadi ardzani/unsplash.com Среди первых пользователей облачного региона — ключевой малайзийский поставщик энергии Petronas, а также SCICOM Berhad, Senang, SIRIM Berhad, TNG Digital (оператор TNG eWallet), Veeam и другие компании. В 2023 году Microsoft уже разработала для Petronas ИИ-инфраструктуру (HPC AI). Также Microsoft выступила с инициативой BINA AI, направленной на содействие ИИ-трансформации в Малайзии. Также в стране компанией будет создан Национальный центр инноваций в области ИИ (Microsoft National AI Innovation Center). Впервые о планах создания облачного региона в Малайзии в Куала-Лумпуре IT-гигант объявил в 2021 году, а в 2024 году компания обязалась инвестировать $2,2 млрд в облачные вычисления и ИИ в стране в следующие четыре года. В 2024 году компания скупала земли в Джохоре, но пока не объявляла о строительстве облачного региона в этом городе. В прошлом месяце Microsoft запустила облачный регион в соседней Индонезии, он тоже стал первым для компании в этой стране. Примечательно, что совсем недавно разразился скандал, связанный с объявлением о строительстве в Малайзии суверенной ИИ-инфраструктуры на базе ускорителей Huawei Ascend. Буквально через день правительственный анонс был дезавуирован премьер-министром Анваром Ибрагимом (Anwar Ibrahim), который прямо назвал прежние заявления подчинённых «преждевременными» — вполне вероятно, под давлением США. |

|